As Mandiant CEO Kevin Mandia’s company prepares to become part of Google, the incident response company continues to investigate many of the most critical cyber incidents.

from Dark Reading https://ift.tt/8x3OJHf

via IFTTT

As Mandiant CEO Kevin Mandia’s company prepares to become part of Google, the incident response company continues to investigate many of the most critical cyber incidents.

from Dark Reading https://ift.tt/8x3OJHf

via IFTTT

Los superordenadores superan largamente la velocidad de cálculo de los de escritorio.

(adsbygoogle = window.adsbygoogle || []).push({});

Todos los años en Linux Adictos nos hacemos eco de la publicación de la lista de los 500 mayores superordenadores del mundo. Y, en un artículo anterior te conté sobre Frontier, el que en este momento no solo es el más rápido del mundo sino también el de mejor rendimiento del mundo.

Como siempre es interesante saber de qué forma llegamos hasta aquí, vamos con una breve historia de los superordenadores.

(adsbygoogle = window.adsbygoogle || []).push({});

Es un equipo capaz de ejecutar cálculos largos y complejos a una velocidad enorme. El rendimiento de una supercomputadora se mide comúnmente en operaciones de punto flotante por segundo (FLOPS) en lugar de millones de instrucciones por segundo (MIPS).

Las supercomputadoras se utilizan en un amplio campo de actividades que necesitan un uso intensivo del cálculo como la mecánica cuántica, el pronóstico del tiempo, la investigación climática, la exploración de petróleo y gas, el modelado molecular (computar las estructuras y propiedades de compuestos químicos, macromoléculas biológicas, polímeros y cristales) y simulaciones de física teórica del tipo de las simulaciones de los primeros momentos del universo, aerodinámica de aviones y naves espaciales, detonación de armas nucleares y fusión nuclear. También en la creación y rompimiento de métodos de cifrados seguros.

En 1956, un equipo de la Universidad de Manchester en el Reino Unido comenzó a desarrollar MUSE. Su objetivo era construir una computadora que pudiera operar a velocidades de procesamiento cercanas a un microsegundo por instrucción, es decir alrededor de un millón de instrucciones por segundo Póco tiempo después se cambió el nombre del proyecto por el de Atlas.

(adsbygoogle = window.adsbygoogle || []).push({});

El primer Atlas se encargó oficialmente el 7 de diciembre de 1962 y fue considerado en el momento de su puesta en marcha como el ordenador más potente del mundo, El Atlas fue pionero en el uso de la memoria virtual y la paginación como una forma de ampliar su memoria de trabajo mediante la combinación de sus 16 384 palabras de memoria principal y 96 000 palabras adicionales de memoria de batería secundaria.

El primer ordenador que provino de una empresa privada fue de una compañía fundada en 1957 por un grupo de ingenieros en computación entre los que se encontraba Seymour Cray quién después se convertiría en una de las personalidades más destacadas de la industria. La empresa se llamó Control Data Corporation y produjo un ordenador llamado CDC 6000 que se componía de cuatrocientos mil transistores, cien millas de cableado, un novedoso sistema de enfriado y una potencia de cálculo record para la época de 3 megaFLOPS. Este ordenador apareció en 1964

El secreto de la velocidad del CDC 6600 estaba en su capacidad de compartir trabajo con los periféricos permitiendo que la CPU se dedicará únicamente al procesamiento de datos. El lenguaje de programación era FORTRAN.

En 1968, Cray produjo la CDC 7600 que también logró el título del ordenador más veloz del mundo. Funcionando a 36 MHz, el 7600 tenía 3,6 veces la velocidad de reloj del 6600, pero, no tuvo el éxito comercial esperado y Cray dejó CDC en 1972 para formar su propia empresa.

(adsbygoogle = window.adsbygoogle || []).push({});

Sin su participación, CDC produjo el STAR-100 con una velocidad de 100 megaFLOPS, es decir tres veces más la velocidad de su antecesor. y utilizaba el llamado procesamiento vectorial, es decir que la CPU estaba diseñada para realizar múltiples cálculos matemáticos en forma simultánea.

Ya en su propia compañía, Seymour Cray produjo tres modelos

Como muchos otros pioneros, Cray no supo detectar el cambio de paradigma y su compañía presentó quiebra en 1995. Mientras tanto sus competidores abrazaban el actual modelo de computación paralela en el que una tarea se divide entre dos o más procesadores que se encargan de resolverla en forma simultánea.

from Linux Adictos https://ift.tt/bZWEFUr

via IFTTT

The innovative ransomware targets NAS devices, has a multitiered payment and extortion scheme as well as a flexible configuration, and takes a heavily automated approach.

from Dark Reading https://ift.tt/7M6sfgP

via IFTTT

A full 77% of tech executives say they’ll increase spending in zero-trust architecture in the coming year.

from Dark Reading https://ift.tt/xEz0NIc

via IFTTT

Cybersecurity needs to shift its thinking ahead of the next disruption, RSA’s CEO said during the opening 2022 conference keynote.

from Dark Reading https://ift.tt/9q76FVi

via IFTTT

By BY ADAM SATARIANO

The agreement aimed to address a consumer frustration and environmental issue.

Published: June 7, 2022 at 11:49AM

from NYT Technology https://ift.tt/Fubp7LJ

via IFTTT

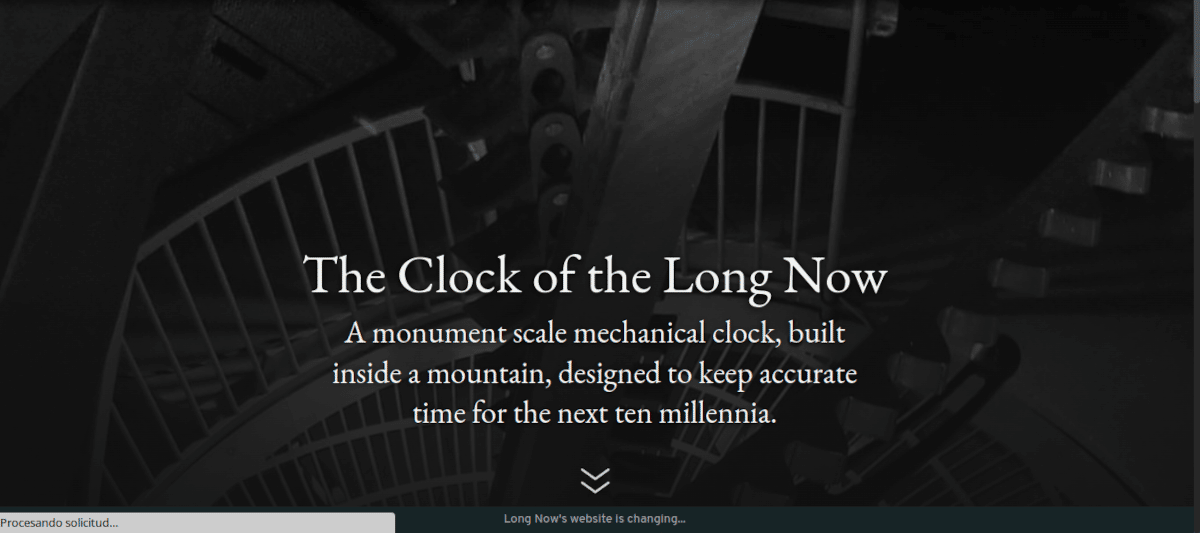

El ordenador más lento del mundo operará un reloj destinado a durar 10000 años

(adsbygoogle = window.adsbygoogle || []).push({});

En un artículo anterior te contaba la historia del que hasta este momento es el ordenador más rápido del mundo. Ahora vamos a ver la historia del que según Google es más lenta que, curiosamente comparten un mismo pionero.

La universidad de Tel Aviv entrega todos los años el premio Dan David que se reparte en tres categorías; pasado, presente y futuro. En la edición del año 2002, el galardonado en la categoría «Presente» fue para el doctor Daniel Hill, el primero en crear un ordenador utilizando la tecnología de procesamiento paralelo que hoy utilizan los superordenadores de todo el mundo. En los comienzos de la década del ochenta, Hill demostró que era posible que un ordenador funcionara con varios procesadores en paralelo. Fue en 1985, mientras trabajaba en su doctorado, que construyó para una empresa privada uno que utilizaba 64000 procesadores.

(adsbygoogle = window.adsbygoogle || []).push({});

Sin embargo, al momento de recibir el premio, Hill parecía haber perdido interés en el tema.

La informatización paralela se ha convertido en una forma muy común de informatización así que, en lo que a mí respecta, el tema se ha agotado.

Toda mi contribución a este campo fue para probar que la informatización paralela era bastante simple y no tan complicado como se pensaba anteriormente

En 1996 se creó el fondo Long Now destinado a financiar la construcción de un reloj de 20 metros en lo alto de la cumbre de la Montaña de la Serpiente en el Parque Nacional Great Basin en el desierto de Nevada. La montaña ya había sido adquirida por un fondo especial. establecido por Mitch Kapor, fundador de la desaparecida compañía de software Lotus, la la familia Jay Walker, creadores de Priceline y Bill Joy, fundador de Sun Microsystem. Esta montaña se eligió porque su cumbre se eleva a una altura de 3.000 metros y está rodeada de un bosque de pinos centenarios, algunos de los cuales superan los 4.900 años.

En el momento de recibir el premio, Hill estaba construyendo un prototipo de dicho reloj, destinado a funcionar nada menos que por 10000 años. Sus planes incluían construirlo completamente de bronce, un material que el hombre conoce hace miles de años. Este reloj será controlado por el ordenador más lento del mundo que puede trabajar con 5 dígitos (Recordemos que tiene que mostrar la fecha después del año 10000) y será operado por lo que se describe como un movimiento mecánico, enorme, voluminoso y preciso. El ordenador será responsable de una precisión de un día cada 20000 años.

(adsbygoogle = window.adsbygoogle || []).push({});

Forma parte de un proyecto de la Long Now Foundation, una entidad sinfines de lucro que busca fomentar el pensamiento a (Muy) largo plazo. A lo que ellos denominan a «escala de civilización».

El reloj, que todavía no fue terminado se llama «Reloj del largo ahora» y como dije más arriba, tendrá escala de monumento, estará construido dentro de una montaña y estará pensado para mantener la hora exacta durante los próximos diez milenios. Cuando esté funcionando requerirá un mantenimiento mínimo y funcionará con energía mecánica recolectada de la luz solar y de las personas que lo visiten.

El Reloj marcará el tiempo con pantallas astronómicas y calendáricas y un generador de campanas diseñado por el compositor Brian Eno que tocará más de 3,5 millones de secuencias únicas de campanadas, una por cada día que se visite el Reloj durante los próximos 10.000 años.

Diez mil años es aproximadamente la edad de la civilización moderna, por lo que el reloj medirá un futuro de civilización igual a su pasado. Esto supone que nuestra civilización está en medio de cualquier viaje en el que estemos, lo que los promotores del proyecto califican como una «muestra de optimismo»

(adsbygoogle = window.adsbygoogle || []).push({});

De la web del proyecto

¿Por qué alguien construiría un reloj dentro de una montaña con la esperanza de que suene durante 10.000 años?

Parte de la respuesta: solo para que la gente haga esta pregunta, y habiéndola hecho, se inciten a conjurar con nociones de generaciones y milenios. Si tiene un reloj en marcha durante 10,000 años, ¿qué tipo de preguntas y proyectos a escala generacional sugerirá? Si un reloj puede seguir funcionando durante diez milenios, ¿no deberíamos asegurarnos de que nuestra civilización también lo haga? Si El Reloj sigue funcionando después de que llevamos mucho tiempo muertos, ¿por qué no intentar otros proyectos que requieren que las generaciones futuras terminen?

La pregunta más importante es, como preguntó una vez el virólogo Jonas Salk: «¿Estamos siendo buenos antepasados?»

from Linux Adictos https://ift.tt/4dDbgv3

via IFTTT

By BY SHIRA OVIDE

What do Google Glass and Pokémon Go have in common? They didn’t change the world.

Published: June 7, 2022 at 11:21AM

from NYT Technology https://ift.tt/dAWvsSx

via IFTTT

(adsbygoogle = window.adsbygoogle || []).push({});

Hace poco el IETF (Grupo de Trabajo de Ingeniería de Internet), que desarrolla los protocolos y la arquitectura de Internet, dio a conocer la noticia de que completó la formación del RFC para el protocolo HTTP/3.0 y publicó las especificaciones relacionadas bajo los identificadores RFC 9114 y RFC 9204.

La especificación HTTP/3.0 recibió el estado de «Estándar propuesto», después de lo cual se comenzará a trabajar para darle a RFC el estado de un borrador de estándar (Draft Standard), lo que en realidad significa una estabilización completa del protocolo y teniendo en cuenta todos los comentarios realizados.

(adsbygoogle = window.adsbygoogle || []).push({});

El protocolo HTTP/3 define el uso del protocolo QUIC (Quick UDP Internet Connections) como transporte para HTTP/2. QUIC es un complemento del protocolo UDP que admite la multiplexación de varias conexiones y proporciona métodos de cifrado equivalentes a TLS/SSL.

El protocolo fue creado en 2013 por Google como una alternativa a TCP + TLS para la Web, resolviendo el problema de la configuración de conexión prolongada y el tiempo de negociación en TCP y eliminando las demoras debido a la pérdida de paquetes durante la transferencia de datos.

Actualmente, la compatibilidad con QUIC y HTTP/3.0 ya está implementada en todos los navegadores web populares. Del lado del servidor, las implementaciones de HTTP/3 están disponibles para nginx (en una rama separada y en forma de un módulo separado), Caddy , IIS y LiteSpeed. HTTP/3 también es compatible con la red de entrega de contenido de Cloudflare.

(adsbygoogle = window.adsbygoogle || []).push({});

Características principales de QUIC:

Ademas de ello, tambien al mismo tiempo, se publicaron versiones actualizadas de las especificaciones para los protocolos HTTP/1.1 (RFC 9112) y HTTP/2.0 (RFC 9113 ), así como documentos que definen la semántica de las solicitudes HTTP (RFC 9110) y los encabezados de control de almacenamiento en caché HTTP (RFC 9111).

De los cambios en la especificación HTTP/1.1, se puede notar la prohibición del uso separado del carácter de retorno de carro (CR) fuera del cuerpo con el contenido, es decir en elementos de protocolo, el carácter CR solo se puede utilizar junto con el carácter de nueva línea (CRLF).

El algoritmo de diseño de solicitudes fragmentadas se ha mejorado para simplificar la separación de campos adjuntos y secciones con encabezados. Se agregaron pautas para manejar contenido ambiguo para bloquear ataques de clase «Contrabando de solicitudes HTTP» que pueden entrometerse en el contenido de las solicitudes de otros usuarios en el flujo entre el frontend y el backend.

(adsbygoogle = window.adsbygoogle || []).push({});

Una actualización de la especificación HTTP/2.0 define explícitamente la compatibilidad con TLS 1.3, se descartaron el esquema de priorización y los campos de encabezado relacionados y el mecanismo de actualización de conexión HTTP/1.1 obsoleto ha quedado obsoleto.

Finalmente si estás interesado en poder conocer más al respecto, puedes consultar los detalles en el siguiente enlace.

from Linux Adictos https://ift.tt/UjMEBbm

via IFTTT

Frontier, de los Laboratorios Nacionales de Oak Ridge es la computadora más rápida del mundo

(adsbygoogle = window.adsbygoogle || []).push({});

Hace unos días, mi compañero Darkcrizt te contaba sobre la lista de ordenadores más rápidos del mundo. En este artículo voy a contarte la característica del primer equipo de la lista, con el que Estados Unidos recupera el liderazgo de la industria de la computación.

Me refiero a Frontier, que oficialmente fue construida por los Laboratorios Nacionales de Oak Ridge para el Departamento de Energía de los Estados Unidos. Digo oficialmente solo porque sería raro que desaprovecharan el potencial de ese equipo para usos militares, pero no me hagan caso. Hoy me puse el gorro de aluminio

(adsbygoogle = window.adsbygoogle || []).push({});

Para entender lo que sigue del artículo comencemos definiendo algunos términos:

FLOPS: Acrónimo en inglés para operaciones de coma flotante por segundo.

Nombre Abreviatura Valor

KiloFLOPS kFLOPS 103

MegaFLOPS MFLOPS 106

GigaFLOPS GFLOPS 109

TeraFLOPS TFLOPS 1012

PetaFLOPS PFLOPS 1015

ExaFLOPS EFLOPS 1018

ZettaFLOPS ZFLOPS 1021

YottaFLOPS YFLOPS 1024

Como vemos, un exaflop equivale a un trillón de operaciones por segundo.

(adsbygoogle = window.adsbygoogle || []).push({});

Lo que llevó al superordenador Frontier del Laboratorio Nacional Oak Ridge del Departamento de Energía a la clasificación más alta como el ordenador más veloz del mundo de la quincuagésima novena edición de la lista de los TOP500 fue su rendimiento de 1,1 exaflops. El sistema Frontier queda en la historia como el primero en alcanzar un nivel hasta ahora no logrado de rendimiento informático conocido como exaescala, Estamos hablando de un umbral de quintillones de cálculos por segundo.

Sin embargo, sus desarrolladores van más lejos. Frontier presenta un rendimiento máximo teórico de 2 exaflops, o dos quintillones de cálculos por segundo, lo que significa diez veces más poder de cálculo que el sistema Summit también desarrollador por los Laboratorios Nacionales de Oak Ridge. El sistema permitirá a los científicos desarrollar tecnologías aplicables en temas de seguridad energética, económica y nacional del país, ayudando a los investigadores a abordar problemas que eran imposibles de resolver hace solo cinco años.

En declaraciones a la prensa, Thomas Zacharia, director del ORNL no fue precisamente modesto:

Frontier está marcando el comienzo de una nueva era de computación a exaescala para resolver los mayores desafíos científicos del mundo.

Este hito ofrece solo una vista previa de la capacidad inigualable de Frontier como herramienta para el descubrimiento científico. Es el resultado de más de una década de colaboración entre los laboratorios nacionales, la academia y la industria privada, incluido el Proyecto de computación a exaescala del DOE (Departamento de Energía de Estados Unidos), que está implementando las aplicaciones, las tecnologías de software, el hardware y la integración necesarios para garantizar el impacto a exaescala.

Pero los logros de Frontier no se limitan al rendimiento. También ocupó el puesto número uno en la lista Green500, que califica el uso de energía y la eficiencia de los sistemas de supercomputación disponibles comercialmente, con un rendimiento de 62,68 gigaflops por vatio. Frontier completó las clasificaciones bianuales con el primer puesto en una categoría más nueva, computación de precisión mixta, que califica el rendimiento en formatos comúnmente utilizados para la inteligencia artificial, con un rendimiento de 6,88 exaflops.

(adsbygoogle = window.adsbygoogle || []).push({});

El trabajo de entrega, instalación y prueba de Frontier comenzó durante la pandemia de COVID-19. Requirió de más de 100 personas del ámbito público y privados que debieron trabajar las 24 horas del día en tareas que van desde la obtención de millones de componentes hasta garantizar las entregas de piezas del sistema en el plazo establecido, pasando por la instalación y prueba cuidadosas de 74 gabinetes de supercomputadoras HPE Cray EX, que incluyen más de 9400 nodos con tecnología AMD y 90 millas de cables de red.

from Linux Adictos https://ift.tt/hnlySoR

via IFTTT