La noticia ya venía dando vueltas desde hace un tiempo. Los rumores de una posible compra de ARM por parte de NVIDIA eran cada vez más fuertes. A pesar de eso, aún quedaban algunas esperanzas, como que no se diese por buena la adquisición, o que Boris Johnson vetase la compra para salvar la sede de Cambridge en Reino Unido. Pero nada de eso ha ocurrido y se han cumplido las peores expectativas. Tampoco es que hubiese muchas esperanzas…

Muchos pueden pensar que el movimiento es algo positivo, y lo cierto es que depende para quien. Desde luego que NVIDIA no ha desembolsado 40.000 millones de dólares por gusto. El movimiento le reportará grandes beneficios y una posición mucho más dominante en el sector, pero desde luego que habrá muchas víctimas por el camino, y la principal podría ser incluso la propia ARM.

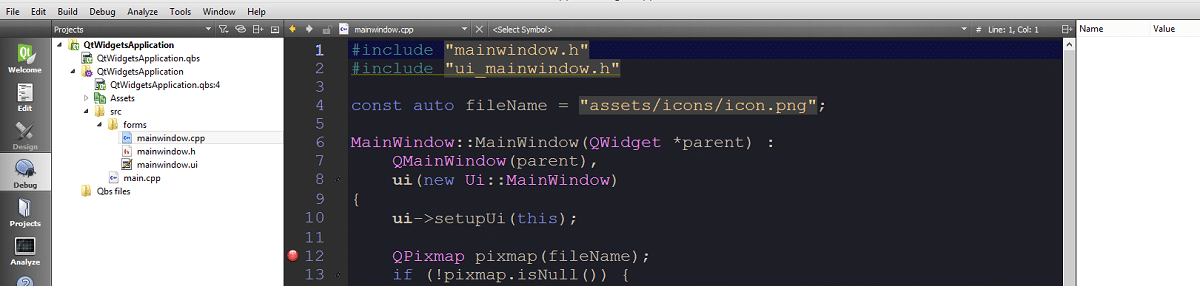

Introducción sobre ARM

Acorn Computer fue una empresa fundada por Hermann Hauser y Chris Curry, y con un proyecto liderado por Sophie Wilson y Steve Furber, entre otros. Ésta comenzaría a desarrollar la arquitectura ARM en 1983, lanzando su primero producto basada en él en 1987. El objetivo inicial era desarrollar un procesador avanzado con una arquitectura similar a los MOS 6502, tipo RISC. Así podría potenciar a su línea de ordenadores personales para sustituir a los chips 6502 en los que se basaban entonces, y cuyos desarrolladores se sentían cómodos.

Al comienzo, Acorn RISC Machine (más tarde Advanced RISC Machine) prácticamente no tenía ningún interés más allá de estos productos propios. Pero con la llegada de los dispositivos móviles, su buena relación rendimiento-eficiencia energética, los puso en el objetivo de todos. Pasaron de ser casi una rareza a estar en multitud de dispositivos, desde modems, routers, TVs, como controladores de multitud de aparatos, hasta los dispositivos móviles.

En los últimos años, empresas como Cavium (ahora propiedad de Marvel) con su ThunderX, Amazon con su Graviton, Fujitsu con su A64FX, el propio proyecto EPI, etc., se interesaron por ARM más allá de la electrónica móvil, para implantarlos también en el ámbito del HPC, como los centros de datos. Y no solo eso, algunos estaban también creando chips de alto rendimiento para comenzar a potenciar algunos PCs, como ciertos Chromebook, la propia empresa de Cupertino con sus Apple Silicon una vez se han desecho de Intel, etc.

En definitiva, “de la noche a la mañana”, ARM pasó de ser algo poco conocido a estar prácticamente en todos los lugares. Algo que también recuerda a la progresión que ha tenido el propio kernel Linux…

Resumiendo mucho, el nuevo negocio de Arm se transformó, siendo una de las empresas más codiciadas. El gigante japonés SoftBank hizo un movimiento desastroso para Europa, comprando la compañía por 28.950 millones de euros, quitándole una de las propiedades tecnológicas más importantes que quedaban en el Viejo Continente (que está en clara dependencia tecnológica de EE.UU. y China). Pero la nipona tuvo su propiedad poco tiempo, ya que la compra se produjo en 2016 y en 2020 la ha vendido…

Y no precisamente porque el negocio no fuera rentable, ya que la forma en la que Arm tiene de aportar su tecnología a los demás es bastante productiva. Y lo hace con dos modelos diferentes:

- Permite usar su ISA ARM, es decir, el repertorio de instrucciones que han diseñado. Todo aquel que quiera usarlo, podrá hacerlo, como ha hecho Fujitsu para sus chips A64FX, que son una microarquitectura diseñada desde cero usando este set de instrucciones. Apple Silicon también es otro de estos casos, usando una ISA ARM, pero con un diseño hecho por la propia Apple para sus chips A-Series.

- Otra posibilidad de las que ofrece es el licenciamiento de sus núcleos IP ya diseñados. Es decir, proveer de una microarquitectura ya hecha para que otros diseñadores puedan integrarlos en sus propios diseños. Es el caso del propio proyecto EPI (CPU ARM + aceleradores RISC-V), o de la mayoría de SoCs para dispositivos móviles, como Qualcomm Snapdragon, Samsung Exynos, Mediatek Helio, HiSilicon Kirin, etc., que integran uno o varios de los núcleos Cortex-A, Cortex-M,… En este caso, se ahorran el costoso proceso de diseñar la microarquitectura.

No confundas la ISA, que es la definición de una serie de instrucciones que se pueden ejecutar, los tipos de datos que se pueden manejar, el formato,… con la microarquitectura, que no es más que la implementación física del diseño capaz de ejecutar dichas instrucciones definidas en la ISA. Una misma ISA puede implementarse de muchas formas, es decir, puede haber muchas microarquitecturas, pero una misma microarquitectura no puede ser compatible con varias ISAs, al menos de forma nativa sin emuladores o artimañas similares.

En ambos casos se paga a Arm por obtener dicho beneficio… Un beneficio que no ha sido el principal revulsivo de NVIDIA para comprar a SoftBank la división Arm, ya que los intereses de Graphzilla van más allá de eso, y se centran en obtener una nueva ventaja y dominio en ciertos sectores como ahora detallaré. Por cierto, como ya sabrás, la compra se cerrará por 40.000 millones de dólares, unos 33.770 millones de euros.

Además, ese modelo es la base del éxito de Arm. Si se eliminase, el éxito podría desparecer y pasar de una Arm triunfante a una mera herramienta para beneficio de NVIDIA. Y quiero dejar claro que esto no es un monólogo contra NVIDIA, pero hay que reconocer que implica riesgos muy graves para todos. Nunca antes hubo tanta preocupación por una adquisición de este calibre.

¿A quién afectará la compra de ARM por parte de NVIDIA?

Algunas voces autorizadas y analistas del sector de la tecnología, y voces bastante cercanas a Arm, aseguran que este acuerdo podría significar el fin de la propia Arm, al menos tal como la conoces ahora. Pasando a ser un producto más del stuff de NVIDIA para monopolizar algunos sectores en los que ahora NVIDIA no puede dominar frente a otras grandes compañías.

Aunque muchos aseguran que los modelos de núcleos IP o el uso de la ISA se mantendrían intactos tras el acuerdo, no todos están igual de seguros. Por tanto, el hecho de que dejasen de proveer alguna de ellas, significaría una gran pérdida y contratiempo para empresas como Samsung, Qualcomm, Mediatek, y un largo etc. que ahora dependen de alguno de esos modelos.

Por cierto, siempre estoy citando empresas como Samsung, Qualcomm, Mediatek, HiSilicon, Apple, etc., pero no son los únicos. También compran licencias otros como Intel, AMD (para sus Security Processor), Rockchip, Marvel, Renesas, STMicroelectronics, NXP, Amazon, Fujitsu, Broadcom (para, entre otras cosas, los chips de la Raspberry Pi) y muchísimos más. Todos ellos ahora están bajo una incertidumbre importante, y muchos de ellos competidores directos de NVIDIA en algunos sectores…

Es más, al pertenecer ahora a una empresa estadounidense, el veto de Trump en sus guerras comerciales contra China o Europa, también podría evitar que algunos usasen la tecnología de Arm, lo que sería realmente catastrófico. Y es que diseñar una microarquitectura competitiva desde cero no es cuestión de días ni de meses, se necesita mucho tiempo y dinero, por lo que pondría a muchas empresas en una clara desventaja.

El peligro no está tanto en NVIDIA en sí, como en las leyes de Estados Unidos que ahora controlarán lo que se hace con Arm. De hecho, Hermann Hauser, cofundador de Arm, escribió una carta al primer ministro de Reino Unido, Boris Johnson para pedirle que impidiera la compra de la compañía. Algo en lo que puedes poner 0 esperanzas teniendo en cuenta que se trata de Boris y de las relaciones que existen entre Reino Unido y EE.UU.. El propio Hermann asegura que la guerra tecnológica y comercial de Estados Unidos vs China dejará un daño colateral que afectará a Reino Unido. Incluso asegura que pone en riesgo los modelos comerciales actuales de Arm que son algo así como un modelo “Suizo” de la industria con más de 500 licenciatarios, muchos de ellos competidores de la propia NVIDIA. Todos ellos podrían perder ese trato de favor actual.

Además, voces como Ryan Smith, de AnandTech, ha expresado que el acuerdo por la adquisición fue la parte fácil del trato. Lo complicado será ahora convencer a todos esos consumidores que ahora dependen de Arm de que se queden.

Una de las voces más críticas ha sido un ex-ingeniero retirado de la industria, como es Chia Kok-Hua. Él ya lleva tiempo alarmando de esta posible compra antes de que se produjera, y asegura tener información de primera fuente sobre el acuerdo, asegurando que no es nada bueno. Él va más allá y asegura que, incluso si NVIDIA mantiene el negocio tal cual está ahora, sus competidores no tendrían mucho que hacer debido a la ventaja con la que contaría ahora NVIDIA.

¿Por qué dice eso? Pues sencillo, y es que ahora Arm solo era un diseñador que no se dedicaba a producir o vender sus propios diseños, sino que simplemente desarrollaba para los demás. Por tanto, no era una amenaza, sino simplemente una fuente de tecnología. En cambio, NVIDIA no solo será una fuente, sino también un competidor, y hará todo lo posible por sacar beneficio de ello, no lo dudes. Usará su estatus para obtener ventaja con el resto.

Por ejemplo, podría introducir cambios en la ISA o el ecosistemas para su propio beneficio, lo cual no sería adecuado para otros diseñadores.

NVIDIA la gran beneficiada

El gran beneficiado de este movimiento es la propia NVIDIA. El movimiento de Arm no ha sido el único que la pone en una situación mucho más ventajosa:

- NVIDIA adquirió Mellanox por 6.900 millones de dólares el pasado año. Por tanto, se queda con las tecnologías de InfiniBand y Ethernet que esta compañía tenía en su poder. Es decir, tecnologías claves para las redes de alta velocidad usados en el sector del HPC. Ahora, esa tecnología está bajo la designación NVIDIA Networking.

- NVIDIA adquiere Arm por 40.000 millones de dólares. Sí, casi 47.000 millones de gasto, pero ahora está en una posición que le va a reportar mucho más que eso.

¿Qué pretendo decir con esto? Pues simple, y es que NVIDIA ahora está en la mejor posición para dominar en el sector HPC, e incluso poner en riesgo empresas muy poderosas como detallo en el siguiente apartado. ¿Motivo? Ninguna otra tiene soluciones integrales, NVIDIA ahora sí: CPUs ARM + GPUs + Redes. ¿Quién puede igualar eso?

x86 en peligro

Como he mencionado en el apartado anterior, incluso x86 podría estar en serio peligro tras este movimiento de NVIDIA. Al menos en el HPC y veremos si también en otros sectores, y no lo digo yo. También hay cierta preocupación entre ciertos trabajadores de empresas como Intel y AMD, que podrían ser otras de las víctimas colaterales de este acuerdo entre Graphzilla y Arm.

En el sector de los centros de datos, cada vez cobra más importancia Arm, y ahora con todas estas adquisiciones, NVIDIA podrá posicionarse como un líder indiscutible e ir desplazando a los chips Intel Xeon y AMD EPYC, que hasta ahora necesitaba junto con sus GPUs, pero ahora ya no.

Recuerda que AMD es una compañía algo más débil que Intel, y podría ser uno de los principales afectados. Y tras este repunte con sus Zen, se podría llevar un nuevo revés con este movimiento de su competidor directo en el ámbito de los gráficos. Intel es el gigante, la Chipzilla, pero una Chipzilla muy muy debilitada y en una situación que no es la mejor, por lo que una leve brisa podría hacer tambalear su liderazgo…

Intel cuenta con un mercado fuerte de CPUs, pero aún está débil en cuanto a soluciones GPU, pese a Intel Xe. AMD le ocurre lo contrario, está relativamente fuerte en GPU, pero su cuota de mercado de CPUs no es tan fuerte como el de Intel, pese a que Zen ha conseguido poner contra las cuerdas a Intel. En cambio, NVIDIA ahora tiene todos los puntos fuertes tras la compra…

Insisto, hay que quitarse el sombrero ante el movimiento de NVIDIA, que ganará mucho, pero que podría traer serios problemas para el resto. Por tanto, aunque sea un movimiento magistral y estratégico, no es nada esperanzador. De hecho, la monopolización y estas ventajas tan abismales siempre terminan perjudicando también a los propios usuarios… Jensen Huang, CEO de NVIDIA, ha sido avispado, pero es un movimiento que algunos como Kevin Krewell, califican de “movimiento muy imprudente“.

Y por cierto, Apple, que se ha librado de Intel y ha emprendido su camino particular con Apple Silicon basados en la ISA ARM, también podrían verse seriamente afectados. Algunos analistas aseguran que tienen dos opciones, o tratar de frenar a NVIDIA, o tomar un camino alternativo. Lo primero no lo veo, ya que Apple no compite directamente contra NVIDIA en el sector de ordenadores, y destinar recursos para una lucha de este calibre no seria beneficioso. Pero es que tampoco la segunda alternativa es una solución barata y para corto plazo…

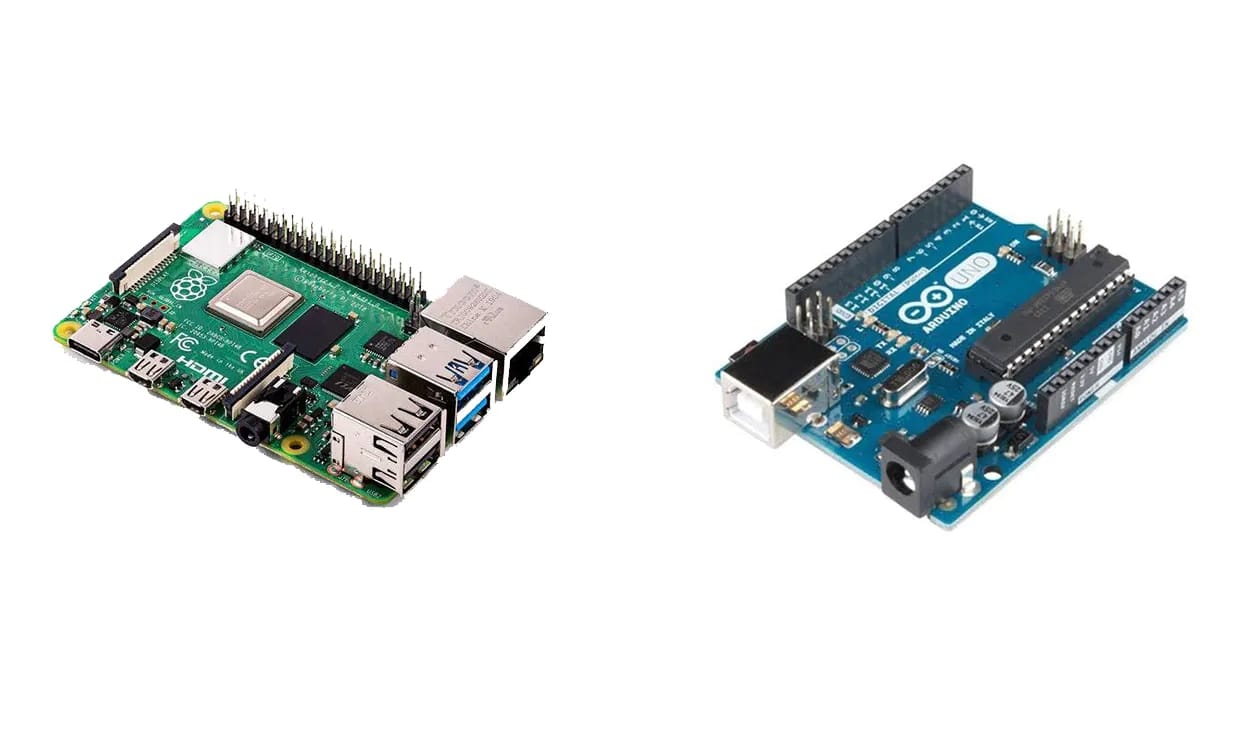

¿Y Raspberry Pi y Arduino?

Se está rumoreando también sobre que la SBC Raspberry Pi está en peligro, debido a que usa chips ARM de Broadcom. Pero no se ha hablado mucho de la placa de desarrollo Arduino, la otra plataforma libre que también cuenta con algunas placas basadas en ARM, y no solo con chips Atmel Atmega.

Dependiendo de los acuerdos de licencias que mantenga NVIDIA, podrían verse afectados en mayor o menor medida. Aún es pronto para decidir, pero no estaría de más que se deshagan de ARM y miren hacia RISC-V, que es una ISA abierta. De hecho, ya existen algunas placas RISC-V de desarrollo muy interesantes…

Actualmente, Broadcom es la que fabrica el SoC de la Raspberry Pi, mientras que Atmel lo hace para Arduino. Dependiendo del trato que tengan estas con NVIDIA dependerá el futuro de estas placas.

¡Ojo! Lo mismo se puede decir de todas aquellas placas compatibles o similares que existen en el mercado, como ODROID, Orange Pi, Banana Pi, UDOO, y placas como Beagle, Tenssy, etc.

Microcontroladores ARM

Otro de los grandes olvidados de los análisis que he visto es el Cortex-M, la serie de MCUs o microcontroladores de Arm. Estos chips están destinados a otros objetivos, como dispositivos empotrados o embebidos, maquinaria industrial, vehículos, IoT, dispositivos cotidianos de consumo, etc.

Esta línea ¿será rentable para NVIDIA? Dependiendo de si es del interés de NVIDIA o no, podría quedar algo relegada, lo que haría a muchos que ahora dependen de ella perder estos diseños IP. Y eso iría más allá del propio sector de los computadores y supercomputadores.

Lo mismo ocurre para los ARM Cortex-R, otra serie de CPUs RISC basada en ARM y, en este caso, optimizada para aplicaciones seguras y críticas, así como para Real-Time (tiempo real). Otra pieza clave para ciertas aplicaciones industriales y de otro tipo.

Desde luego que, aunque no es tan popular, es un sector muy jugoso. Y nuevamente nos encontramos con otra duda. Y es que, aunque NVIDIA mantenga el desarrollo de estas MCUs, podría sacar una gran ventaja de ello en sectores claves para el futuro como los vehículos, IoT, etc. Gran beneficio de uno, perjuicio de muchos…

Afectados colaterales: RISC-V

NVIDIA no es la única beneficiada de este movimiento en la compra de Arm. Hay otro beneficiado, pero casi de forma colateral. Sin buscarlo, la ISA RISC-V podría ser la gran vencedora, ya que muchos de esos clientes actuales de Arm descontentos, podrían terminar recalando en RISC-V, lo que atraería más inversión, desarrollo, y potenciación del ecosistema.

Por cierto, aunque NVIDIA sea uno de los partners de RISC-V Foundation, no creas que lo ha hecho pensando en ellos. De hecho, si RISC-V comienza a ganar adeptos tras el movimiento, ésta pasaría a transformarse también en un enemigo para la propia NVIDIA. Así que ya veremos qué ocurre con su contribución actual…

Mike Demler, uno de los analistas senior de The Linley Group, también ha asegurado que “personas clave podrían desertar. Más clientes de Arm podrían mirar a RISC-V“, refiriéndose al acuerdo entre NVIDIA y Arm.

Quizás otros como MIPS y OpenPOWER también podrían verse beneficiados con este acuerdo, ya que estas ISAs podrían cobrar interés si NVIDIA decide hacer artimañas extrañas con ARM. Veremos…

Conclusión

En definitiva, el movimiento es un claro paso adelante para NVIDIA, pero un serio retroceso para todos los demás. E incluso si mantuvieran sus actuales clientes de Arm y no afectase a los actuales modelos de licencias, la propia NVIDIA obtendrá una ventaja en el mercado, y eso podría tener sus consecuencias también en los clientes y usuarios, ya que la competencia se verá afectada.

Mucha certeza de que NVIDIA ganará, pero mucha incertidumbre en todo lo demás… El tiempo dirá.

Ahora resonará la famosa frase que Linus Torvalds pronunciara hace tiempo refiriéndose a NVIDIA… quizás ahora tiene un poco más de sentido. Y ahora tocará mirar hacia RISC-V y desearle toda la suerte por el bien de todos…

from Linux Adictos https://ift.tt/33zBD2P

via IFTTT