(adsbygoogle = window.adsbygoogle || []).push({});

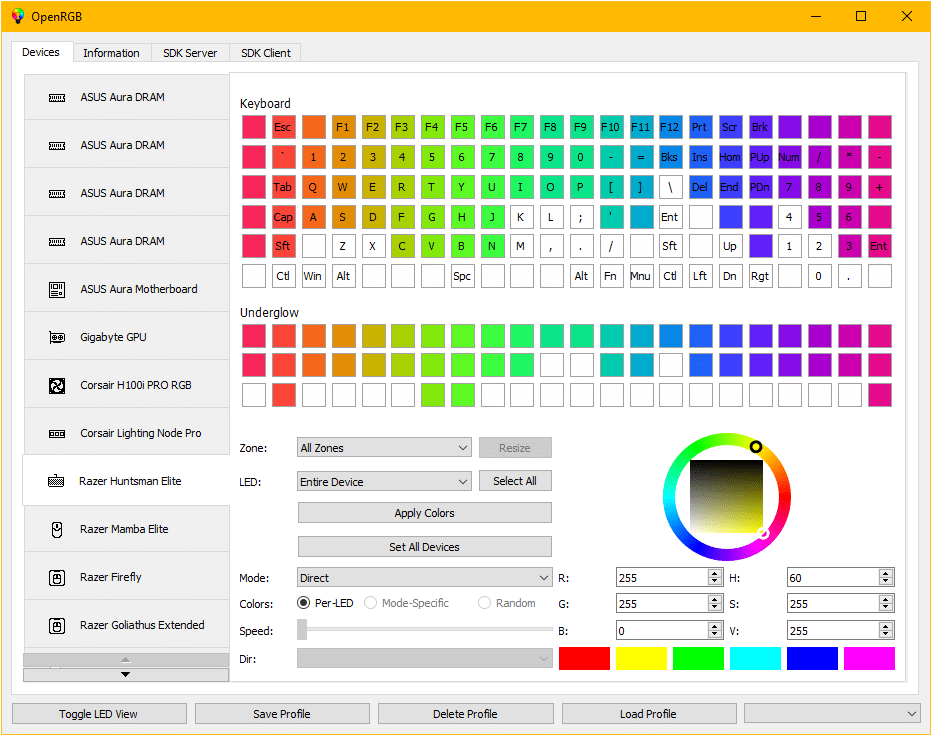

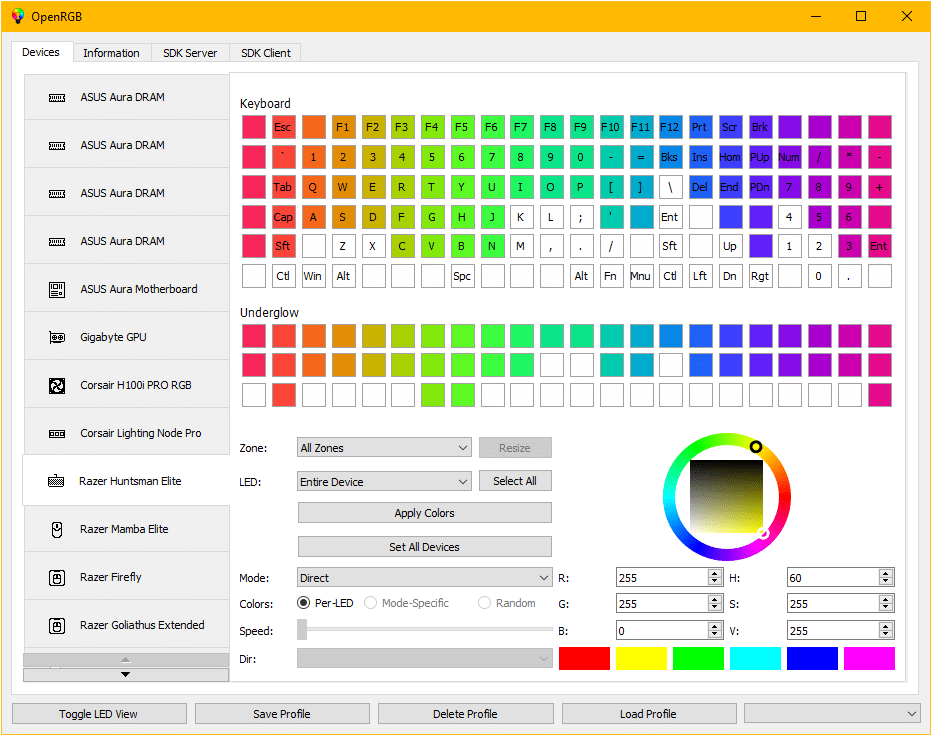

Para quienes desconocen de OpenRGB, deben saber que es un software de control de dispositivos de iluminación RGB y es una implementación ofrecida es bastante sólida que admite varias generaciones de controladores Aura en las plataformas Intel y AMD, lo que elimina la necesidad de instalar aplicaciones propietarias oficiales que están vinculadas a un fabricante específico.

OpenRGB es compatible con controladores compatibles con Aura utilizados en varios fabricantes de módulos de memoria RGB, incluidos G.Skill Trident Z RGB y otros.

(adsbygoogle = window.adsbygoogle || []).push({});

El proyecto ofrece una biblioteca de funciones con una API universal para controlar la retroiluminación de las aplicaciones, una utilidad de consola y una interfaz gráfica en Qt. Admite la elección de modos de cambio de color (onda de color, etc.), control de las zonas de retroiluminación, aplicación de efectos avanzados, definición del diseño de los LED y sincronización de la retroiluminación con las acciones realizadas (música de color, etc.).

(adsbygoogle = window.adsbygoogle || []).push({});

Principales novedades de OpenRGB 0.7

En esta nueva versión que se presenta se ha añadido un menú de configuración y en el cual ahora, para configurar una funcionalidad específica (E1.31, QMK, Philips Hue, Philips Wiz, dispositivos Yeelight y dispositivos controlados a través de un puerto serie, por ejemplo, basado en Arduino), no es necesario editar el archivo de configuración manualmente.

Otro de los cambios que se implementa, es en el control de inicio automático de OpenRGB el cual al iniciar el sistema ahora está disponible en el menú de configuración. Puede especificar acciones adicionales que OpenRGB llevará a cabo en este lanzamiento (aplicando perfiles, lanzando en modo servidor).

Tambien se destaca que se agregó la capacidad de guardar configuraciones en un dispositivo si hay memoria Flash en el dispositivo. El ahorro se realiza solo mediante comando para evitar el desperdicio de recursos Flash. Anteriormente, no se realizaba el guardado para dichos dispositivos por las mismas razones.

Los complementos ahora tienen un mecanismo de control de versiones para evitar fallas debido a compilaciones heredadas con versiones más nuevas de OpenRGB.

(adsbygoogle = window.adsbygoogle || []).push({});

Ademas se agregó un control deslizante para controlar el brillo de los dispositivos que tienen esta configuración además de la configuración de color, tambien se agregó la capacidad de instalar complementos a través del menú de configuración y se agregó una consola de registro para facilitar la obtención de información sobre fallas de nuevos usuarios.

Finalmente, tambien se menciona que cuando se encuentran nuevos dispositivos que requieren un ajuste de dimensionalidad (controladores ARGB), OpenRGB le pedirá al usuario que lo haga.

En cuanto a los problemas que fueron resueltos:

- Se corrigieron problemas con la detección de dispositivos USB relacionados con la interfaz / página / valores de uso que difieren entre sistemas operativos

- Mapas de ubicación de teclas corregidos (diseños) en muchos dispositivos.

- Formato mejorado de registros

- Se corrigió el problema de inicialización de múltiples WMI (lo que resultó en la imposibilidad de volver a detectar dispositivos SMBus)

- Interfaz de usuario ligeramente mejorada

- Se corrigieron fallas de la aplicación al conectar ratones Logitech (G502 Hero y G502 PS)

- Se corrigieron fallas de la aplicación al descargar complementos

En cuanto a la lista de nuevos dispositivos soportados, los podremos consultar aquí. Puedes consultar la compatibilidad de hardware que actualmente soporta esta utilidad en el siguiente enlace.

¿Cómo instalar OpenRGB en Linux?

Para quienes estén interesados en poder instalar OpenRGB en su sistema, deben seguir las instrucciones que compartimos a continuación.

Lo primero que debemos hacer es instalar la última edición de Qt Creator.

En el caso de Ubuntu y derivados debemos de instalar algunas dependencias:

sudo apt install qt5-default libusb-1.0-0-dev libhidapi-dev

Ahora vamos a obtener la utilidad con el comando:

git clone https://gitlab.com/CalcProgrammer1/OpenRGB

Hecho esto ahora debemos de actualizar los submodulos:

git submodule update --init –recursive

Y aquí podemos hacer dos cosas una de ellas es abrir el proyecto con QT creator o realizar la compilación de este en el sistema.

Para realizar la compilación basta con ejecutar los siguientes comandos:

cd OpenRGB

qmake OpenRGB.pro

make -j8

./OpenRGB

Al finalizar la compilación debemos de permitir el acceso a SMBus.

En Intel podemos hacerlo con el comando:

modprobe i2c-dev i2c-i801

O en el caso de AMD, debemos primero enumerar los controladores SMBus con:

sudo i2cdetect -l

Ya identificado el controlador debemos de otorgar permisos al controlador, por ejemplo:

sudo chmod 777 /dev/i2c-0

Por último se debe tomar en cuenta que todavía se carece de algunas capacidades para persistir en todos los reinicios, pero la funcionalidad principal de configurar colores y modos son estables.

Si quieres conocer más al respecto puedes consultar los detalles en el siguiente enlace.

from Linux Adictos https://ift.tt/3sMxerQ

via IFTTT