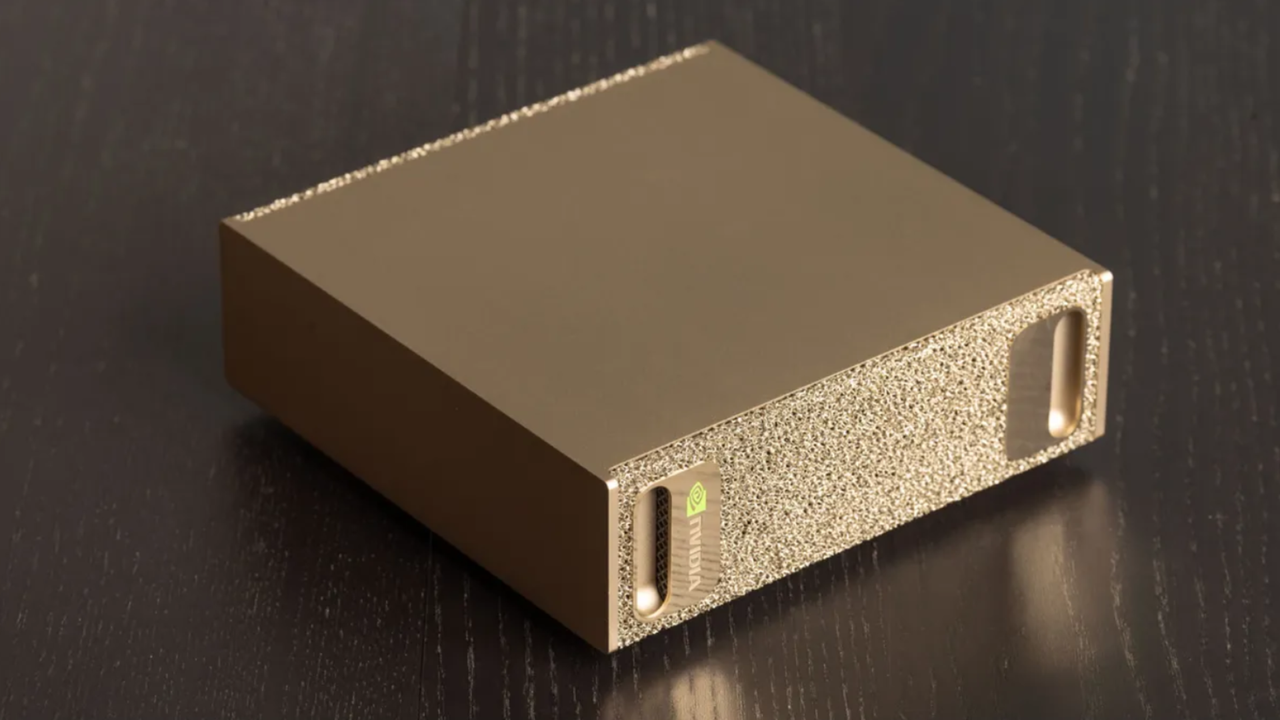

En un panorama donde las cargas de inteligencia artificial demandan rapidez, control de datos y una infraestructura confiable, Nvidia presenta DGX Spark como una solución para ejecutar workloads de IA de manera local con alto rendimiento. Con 128 GB de memoria, una GPU Blackwell y soporte completo para CUDA, esta plataforma está diseñada para acelerar desde el prototipado hasta la producción sin depender de infraestructuras externas.

Capacidades clave

– Memoria amplia: 128 GB de memoria permiten manejar modelos grandes y conjuntos de datos significativos sin recurrir a almacenamiento externo para cada operación, reduciendo la latencia y simplificando el flujo de trabajo.

– GPU Blackwell: una arquitectura de próxima generación diseñada para ofrecer mayor rendimiento computacional y eficiencia energética, optimizada para tareas de entrenamiento, inferencia y evaluación de modelos de IA.

– Soporte CUDA: compatibilidad con el ecosistema CUDA garantiza acceso a bibliotecas, herramientas y pipelines líderes en la industria, facilitando la portabilidad de modelos y la integración con frameworks como TensorFlow, PyTorch y MXNet.

– Rendimiento local: la combinación de memoria, potencia de cómputo y herramientas de desarrollo habilita cargas de trabajo locales de IA con latencias reducidas, mayor control de datos y operación continua incluso sin conectividad a la nube.

Beneficios para equipos de IA

– Latencia y control: al ejecutar procesos de IA localmente, se minimiza el retraso de ida y vuelta a la nube y se refuerza la seguridad de los datos sensibles durante el desarrollo y la validación.

– Productividad acelerada: los equipos pueden iterar rápidamente sobre modelos, ajustar hiperparámetros y realizar pruebas de validación sin depender de entornos externos, lo que reduce ciclos de desarrollo.

– Escalabilidad modular: la infraestructura puede adaptarse a cargas crecientes, manteniendo consistencia en el rendimiento gracias a una arquitectura optimizada para cargas de trabajo intensivas en memoria y cómputo.

– Ecosistema CUDA: el soporte de CUDA facilita la integración con herramientas existentes, bibliotecas optimizadas y flujos de trabajo que el equipo ya conoce, promoviendo la continuidad operativa.

Casos de uso recomendados

– Entrenamiento y evaluación de modelos grandes en un entorno controlado, sin comprometer la seguridad de los datos de entrenamiento.

– Inferencia de baja latencia para aplicaciones en tiempo real, incluyendo procesamiento de señales, visión por computadora y lenguaje natural en escenarios locales.

– Prototipado y pruebas de concepto de IA en un entorno aislado antes de escalar a plataformas en la nube o en el edge.

– Integración de pipelines de datos locales para flujo continuo de entrenamiento, validación y despliegue de modelos.

Consideraciones para la implementación

– Requisitos de software: asegurar compatibilidad con las versiones de CUDA, cuDNN y las bibliotecas utilizadas en los proyectos de IA.

– Gestión de recursos: planificar la distribución de memoria y cómputo entre procesos, experimentos y modelos concurrentes para evitar cuellos de botella.

– Costos y sostenibilidad: evaluar el consumo energético y la relación costo-beneficio frente a soluciones en la nube o híbridas, buscando un equilibrio entre rendimiento y eficiencia.

– Actualizaciones y soporte: mantener actualizados drivers y herramientas de desarrollo para aprovechar mejoras de rendimiento y nuevas bibliotecas.

Conclusión

DGX Spark representa una propuesta sólida para equipos que priorizan la ejecución local de IA sin sacrificar rendimiento ni flexibilidad. Al combinar 128 GB de memoria, una GPU Blackwell y un ecosistema CUDA, la plataforma crea un entorno de desarrollo y producción donde la latencia se minimiza, la seguridad de datos se fortalece y la productividad se mantiene alta. Si tu estrategia de IA exige operaciones locales eficientes con un conjunto de herramientas establecido, DGX Spark merece una evaluación detallada para entender cómo puede encajar en tu ruta de innovación.

from Latest from TechRadar https://ift.tt/a1kNOIb

via IFTTT IA