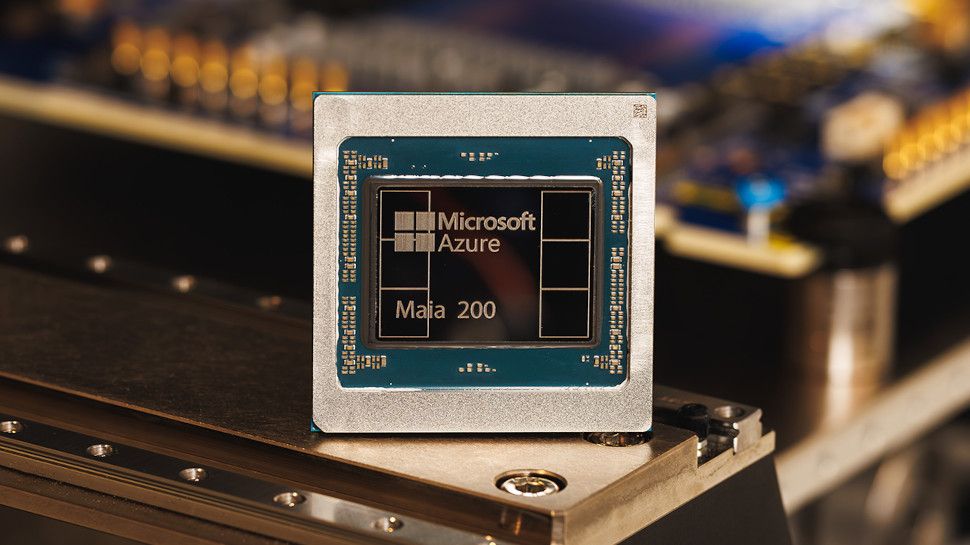

En la era de la IA de gran escala, cada nuevo salto en la potencia de cómputo redefine lo que es posible en la inferencia. Maia 200, una plataforma cuyo diseño presume un salto significativo en densidad de transistores, se coloca en el centro de estas conversaciones. Según Microsoft, Maia 200 ofrece “powerhouse” AI inferencing possibilites.

Con más de 100 mil millones de transistores en un solo die, Maia 200 promete un nivel de paralelismo y una capacidad de coordinación entre unidades de procesamiento de inteligencia artificial que van más allá de lo que hemos visto en generaciones anteriores. Esta densidad abre la puerta a modelos de IA más grandes, a flujos de trabajo concurrentes y a mejoras en la latencia de inferencia. Sin embargo, más transistores no siempre significan mayor eficiencia; el rendimiento real depende de la arquitectura, del ancho de banda de memoria y de las estrategias de gestión de datos.

La arquitectura detrás de Maia 200, con aceleradores dedicados para inferencia, optimización de memoria y mecanismos de eficiencia energética, será determinante para convertir esa cantidad de transistores en beneficios reales. Un mayor paralelismo exige una gestión sofisticada de datos: ancho de banda sostenido, latencias bajas y una coherencia entre núcleos que evite cuellos de botella en tareas de inferencia de gran tamaño. En este sentido, Maia 200 podría destacarse si integra un ecosistema de herramientas y bibliotecas capaz de aprovechar de forma eficiente la capacidad de cómputo disponible.

En cuanto a aplicaciones, las implicaciones son amplias. En la nube, una plataforma con Maia 200 podría acelerar servicios de generación de lenguaje, visión por computadora, IA multimodal y procesamiento de grandes modelos de IA, reduciendo tiempos de respuesta y permitiendo experimentos más ambiciosos. En escenarios de borde o híbridos, la pregunta clave será si la plataforma ofrece escalabilidad y eficiencia energética para despliegues de gran tamaño sin comprometer la seguridad y la gestión de datos.

Si bien los avances son prometedores, también existen desafíos. El volumen de transistores implica costes de fabricación, consumo de energía y complejidad de diseño. Además, la competencia en el segmento de aceleradores para IA es muy intensa, con varias empresas luchando por equilibrar rendimiento, densidad y coste. La adopción de Maia 200 dependerá, entre otros factores, de la madurez del ecosistema de desarrollo, de las herramientas de optimización y de la capacidad de los proveedores para traducir la promesa en resultados tangibles para los clientes.

En resumen, Maia 200 representa un hito que podría redefinir el paisaje de la inferencia de IA a gran escala. Si las promesas se confirman en pruebas del mundo real, podríamos ver una inclinación acelerada hacia modelos más ambiciosos y servicios de IA más rápidos y eficientes. El tiempo dirá qué tanto de esa potencia se convierte en valor práctico para empresas y desarrolladores.

from Latest from TechRadar https://ift.tt/CNaHkRG

via IFTTT IA