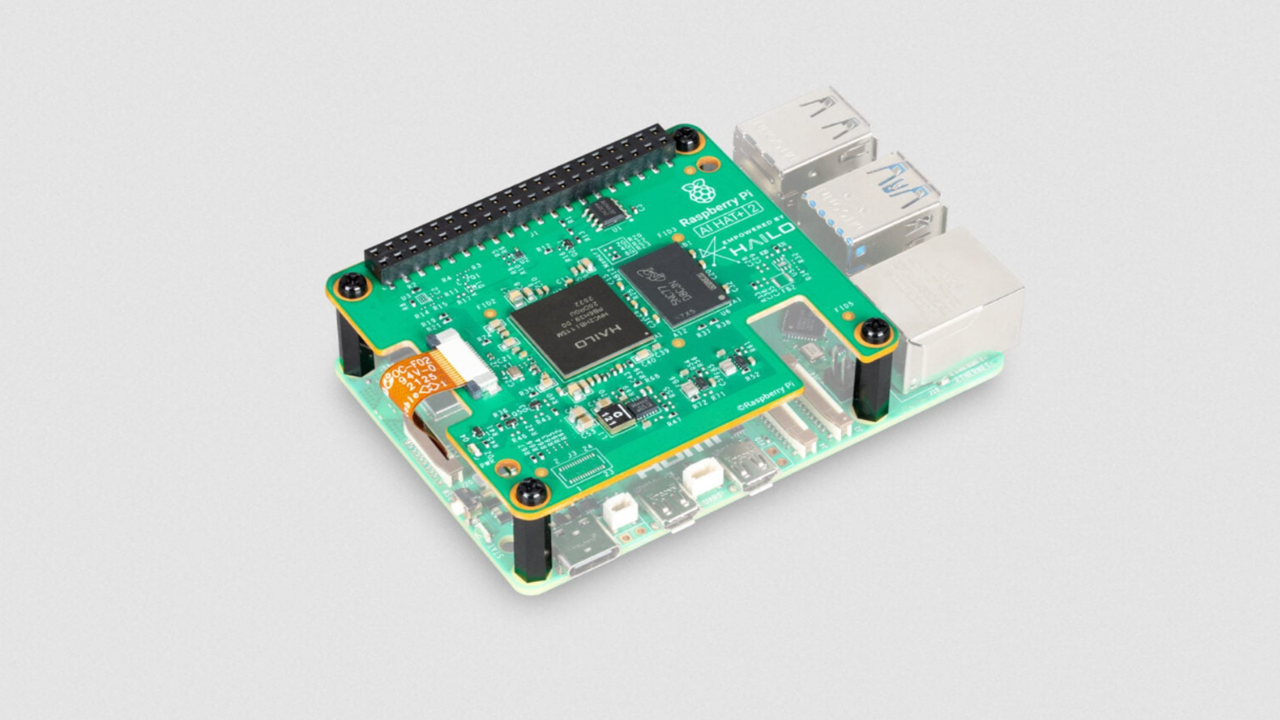

El crecimiento de la IA en el borde exige soluciones que combinen rendimiento robusto, tamaño compacto y gestión local de datos. Raspberry Pi AI HAT+ 2 llega en ese contexto para ofrecer una plataforma que permite ejecutar modelos de gran tamaño y visión multilingüe sin depender de la nube. Con una capacidad de hasta 40 TOPS de cómputo, 8 GB de memoria y conectividad PCIe, este sistema está pensado para aplicaciones reales en casa, en talleres o en entornos industriales.

Rendimiento y arquitectura: el HAT+ 2 integra un acelerador de IA dedicado que maneja operaciones de inferencia con eficiencia y soporte para modelos cuantizados. La conectividad PCIe facilita ampliar la capacidad de cómputo o almacenamiento mediante tarjetas aceleradoras adicionales o unidades SSD rápidas, permitiendo trabajar con modelos que requieren más recursos que los disponibles en la placa base.

Memoria y gestión de modelos: con 8 GB de memoria, se pueden cargar y ejecutar modelos moderados o realizar particionamiento de tareas entre la CPU y el acelerador. Para maximizar el rendimiento, se recomienda utilizar modelos cuantizados de 8 bits o binarios optimizados, así como estrategias de carga fuera de la GPU/ accelerador cuando sea posible.

Casos de uso prácticos: la plataforma está diseñada para ejecutar cargas locales de LLM y VLM sin depender de la nube. Entre los escenarios más comunes se encuentran:

– Asistentes personales offline que resuelven consultas y realizan tareas sin enviar datos a la red.

– Descripción y análisis de imágenes para cámaras de seguridad, drones o robots con capacidad de lenguaje.

– Prototipos de aplicaciones de generación de contenido y traducción en dispositivos de borde.

– Soluciones de automatización que requieren respuesta rápida y baja latencia.

Guía rápida de implementación: para empezar, asegúrate de contar con una Raspberry Pi compatible y la placa AI HAT+ 2 correctamente instalada en la cabecera. Instala el sistema operativo y los controladores necesarios, habilita la conectividad PCIe y conecta cualquier dispositivo externo si fuera necesario. Integra un entorno de inferencia optimizado (por ejemplo, herramientas de PyTorch/TensorFlow Lite o soluciones específicas para LLMs y VLMs) y carga modelos cuantizados que se ajusten a los 8 GB disponibles. Optimiza la memoria con técnicas como el batching y el encolado de entradas para mantener la latencia en niveles aceptables.

Consideraciones y buenas prácticas:

– Alimentación y refrigeración adecuadas para mantener el rendimiento sostenido.

– Planificación de capacidad: comienza con modelos más pequeños y escala a medida que sea necesario, especialmente si se combinan LLMs y VLMs en la misma plataforma.

– Seguridad y privacidad: aprovecha la ejecución local para mantener datos sensibles fuera de la nube.

Mirada hacia el futuro: la combinación de HAT+ 2 con opciones de expansión PCIe abre la puerta a soluciones cada vez más complejas en el borde, desde modelos de IA generativa hasta capacidades avanzadas de visión por máquina, todo ello manteniendo el control y la resiliencia de un entorno local.

Conclusión: Raspberry Pi AI HAT+ 2 representa una propuesta sólida para desarrolladores y emprendedores que buscan desbloquear capacidades de IA en dispositivos de borde, con un balance claro entre rendimiento, memoria y flexibilidad de expansión. Si tu objetivo es experimentar con LLMs y VLMs a nivel local, esta plataforma ofrece un punto de partida coherente y escalable.

from Latest from TechRadar https://ift.tt/LcYz9O7

via IFTTT IA